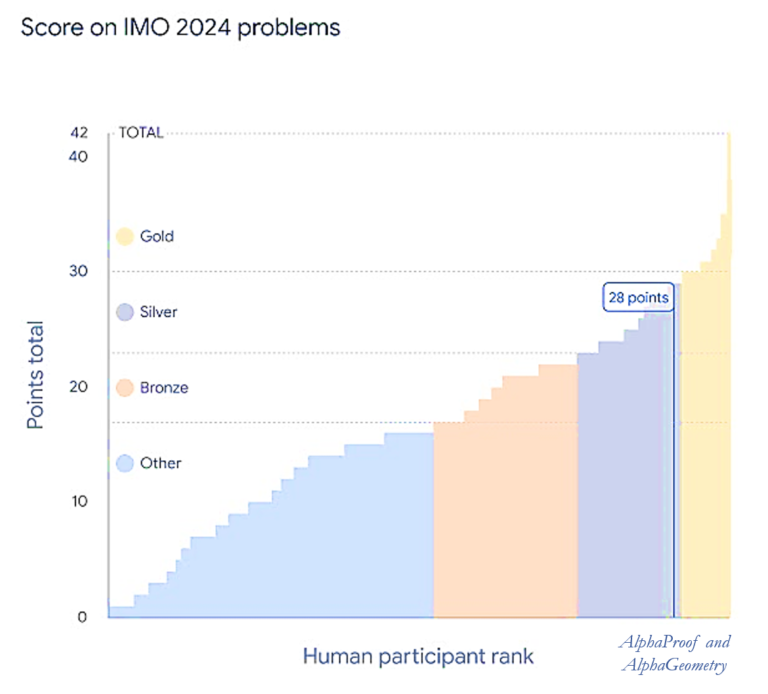

المپیاد ریاضی یکی از قدیمیترین رقابتهای حاضر در میان علاقهمندان جوان ریاضیات در دنیاست. این مسابقه از سال ۱۹۵۹ میلادی (۱۳۳۸ شمسی) تاکنون، همه ساله بین بهترین دانشآموزان کشورهای جهان برگزار میشود. آزمون المپیاد شامل شش مسئله دشوار در موضوعات جبر، هندسه، ترکیبیات و تئوری اعداد است و حل آنها به ساعتها فکر کردن متمرکز نیاز دارد. سوالات این آزمون همیشه جدید است و غالبا توسط برجستهترین ریاضیدانان جهان مثل برندگان مدال فیلدز طرح میشود تا هیچ شرکتکنندهای با مشاهده نمونهای نزدیک به سوالات آزمون از امتیازی نسبت به سایر شرکتکنندگان برخوردار نباشد. اما در آخرین آزمون بینالمللی المپیاد ریاضی در سال ۲۰۲۴ یک اتفاق کاملا جدید افتاد و توجه بسیاری را به خود جلب کرد. در آخرین المپیاد ریاضی، یک مدل هوش مصنوعی موفق شده امتیازی معادل مدال نقره مسابقه را کسب کند.

در این آزمون ابتدا هر شش سوال به زبان ریاضی درآمده و به این صورت وارد سیستمهای آلفاپروف[۱] و آلفاجیومتریِ[۲] گوگل شداند تا تلاش برای حل آنها آغاز شود. سیستم گوگل موفق شده تا از شش سوال، یک سوال را در چند دقیقه ابتدایی حل کند، حل سه سوال دیگر سه روز طول کشیده و دو سوال در نهایت بدون راه حل باقی مانده است (زمان آزمون ۴.۵ ساعت است). تلاش این دو سیستم گوگل در نهایت به کسب امتیاز ۲۸ از ۴۲ و رتبه ۵۹ از ۶۰۹ نفر شرکتکننده شده است (۲۹ کمترین امتیاز برای کسب مدال طلا بوده است)[۳].

توانایی استدلال ریاضی در این سطح، یک قابلیت جدید هوش مصنوعی است که نسخههای قبلی آن را نداشتهاند. این قابلیت سبب شده چشمانداز تازهای برای حل مسائل باز و بغرنج علوم توسط هوش مصنوعی در آینده ایجاد شود. چه چیزی سبب پیدایش قابلیتهای تازه در نسلهای جدید مدلهای هوش مصنوعی میشود؟

در سالهای اخیر، هوش مصنوعی به لطف مدلهای زبانی بزرگ (LLMs) تحولات عظیمی را تجربه کرده است. این مدلها که چتجیپیتی و لاما نمونههایی از آنها هستند، به صورت بیسابقهای تواناییهایی شبیه استدلال منطقی، حل مسائل ریاضی و حتی سطوحی از خلاقیت در نوشتن را نشان دادهاند. این تواناییها چگونه ظهور کردهاند؟ چه چیزی باعث میشود ویژگیهای جدیدی در این مدلها پدیدار شود؟

اغلب مدلهای هوش مصنوعی جدید مثل مدلهای زبانی بزرگ با تکیه بر شبکههای عصبی عمیق کار میکنند. در این مدلها، بزرگی شبکه مدل یا به عبارت دقیقتر تعداد یالها، (پارامترهای قابل تنظیم) به عنوان معیاری برای انعطاف و پیچیدگی مدل در نظر گرفته میشود. برای مثال، مدل جیپیتی۳ دارای ۱۷۵ میلیارد پارامتر است که هنگام مدلسازی باید مقدار آنها با به کارگیری یک سختافزار بزرگ تعیین شود، در حالی که نسخههای اولیه این مدلها تنها میلیونها یا چند میلیارد پارامتر بیشتر نداشتند.

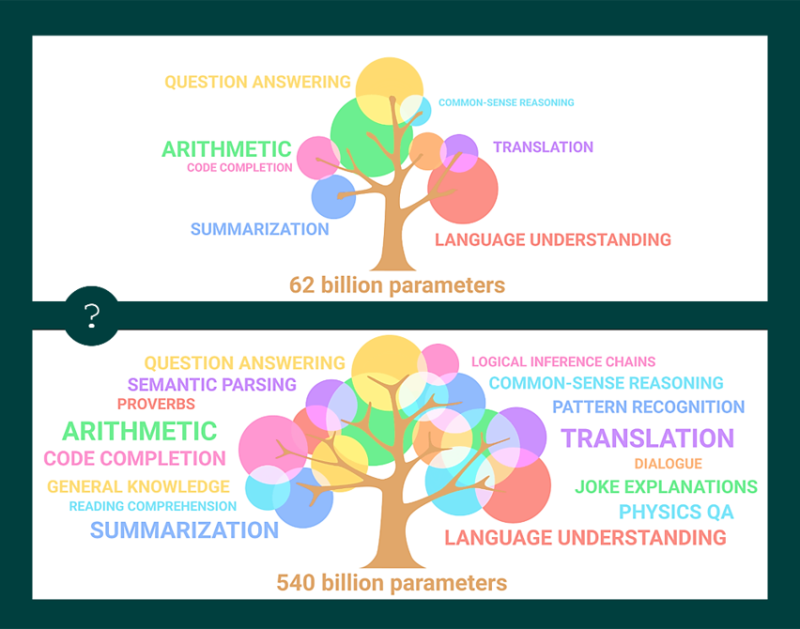

مشاهده این روند افزایشی این ایده را به ذهن متبادر میکند که با افزایش تعداد پارامترها، نه تنها توانایی و دقت مدل در تولید متن بهبود مییابد، بلکه قابلیتهای غیرمنتظره و جدیدی مثل خلاقیت و استدلال نیز ظاهر میشوند.

به عنوان مثال در حالی که جیپیتی۲ با ۱.۵ میلیارد پارامتر قابلیتی فراتر از تولید متنهای روان نداشت و جیپیتی۳ با۱۷۵ میلیارد پارامتر قابلیتهای جدیدی مثل ترجمه، خلاصهسازی، کدنویسی و درک برخی از مسائل منطقی پیدا کرده بود، جیپیتی۴ با بیش از یک تریلیون پارامتر از آنچه در حوزه پردازش زبانهای طبیعی تصور شده بود، فراتر رفت و تواناییهای جدیدتری مثل درک تصاویر و حل مسائل ترکیبی بروز داد[۴].

پیدایش قابلیتهای جدید در هوش مصنوعی در سالهای اخیر مورد توجه زیادی قرار گرفته است، چراکه این تصور به وجود آمده که با تامین سختافزاری و صرف انرژیِ بیشتر و آموزش مدلهای بزرگتر، تواناییهای تازه و پیشبینیناپذیری پدید میآیند[۵]. این قابلیتها هم از جهت امکانات و هم از جهت مخاطراتی که ایجاد میکنند مورد توجه قرار گرفتهاند.

آنچه باعث این تصور شده در واقع این است که این تواناییها را نمیتوان در مدلهای کوچکتر – حتی اگر همان دادهها را آموزش داده باشند – مشاهده کرد. شرکت اوپناِیآی در یکی از مطالعات خود مدعی شده برخی از تواناییهای منطقی تنها زمانی ظاهر میشوند که مدل به حد مشخصی از تعداد پارامترها برسد. برای مثال، توانایی حل مسائل جبری در مدلهایی با کمتر از ۱۰ میلیارد پارامتر دیده نمیشد، اما با افزایش مقیاس، این توانایی به صورت ناگهانی و شگفتانگیز ظاهر شد[۶].

این مشاهده تا حدی شبیه به ایده پیدایش ویژگیهای جدید[۷] در مطالعات سیستمهای پیچیده[۸] است. منظور از پدیدار شدن ویژگیهای جدید، ویژگیهایی است که با نگاه به اجزای تشکیل دهنده سیستم قابل مشاهده نباشد و مشاهده آن را احتمالا باید به تعاملات پیچیده بین نورونها در شبکه عصبی مصنوعی مدل نسبت داد[۹]. در شبکههای عصبی، افزایش پارامترها به معنای افزایش تعداد ارتباطات ممکن بین نورونها است. این تعاملات در مقیاس بزرگ به مدل اجازه میدهد تا الگوهای پیچیدهتری را شناسایی کند که در مقیاسهای کوچکتر دستنیافتنی هستند. اگر یک ویژگی با تعداد مشخصی از پارامترها محقق شود، آیا با افزایش تعداد پارامترهای بیشتر میتوان به ویژگیهای مهمتری دست یافت؟ آیا محدودیتی وجود دارد؟

به نظر میرسد سرمایهگذاران این حوزه نیز با همین تصور به گردآوری خوشههای بزرگتری از پردازندهها روی آوردهاند و به همین دلیل نیز هر بار ابعاد مدل و اندازه پردازندهها در خبرها مورد توجه قرار میگیرد[۱۰].

البته این رویکرد در میان پژوهشگران هوش مصنوعی منتقدانی نیز دارند. آنها معتقدند افزایش مقیاس و بروز قابلیتهای جدید نمیتواند به صورت نامحدود ادامه یابد و بحثهای زیادی در این مورد وجود دارد. ظهور قابلیتهای جدید با افزایش پارامترها یک امر تضمینشده نیست و باید محدودیتهای آن را مورد بحث قرار داد[۱۱]. بعضی از این تواناییها ممکن است به دادههای آموزشی خاص مثل یادگیری اطلاعات زمینه[۱۲] یا ساختار معماری متفاوتی نیاز داشته باشند. آنها مدعیاند ایده ظهور بیپایان تواناییهای جدید با افزایش اندازه مدل ممکن است اغراقآمیز و نامرتبط باشد و اظهار نظر در این مورد بررسیهای دقیق و جامعتری دارد[۱۳].

به نظر شما مهمترین عامل بروز قابلیتهای جدید در مدلهای زبانی بزرگ، آموزش مدلهایی با تعداد پارامتر بیشتر است یا میتوان از عوامل دیگری نیز به عنوان نقاط بروز قابلیتهای جدید در این مدلها یاد کرد؟ محدودیتهای زبانی چیست؟

ادامه دارد ...

ارجاع و پانویس

[1] AlphaProof

[2] AlphaGeometry

[3] AI achieves silver-medal standard solving International Mathematical Olympiad problems, Google DeepMind, AlphaProof and AlphaGeometry teams 25 July 2024 (+)

[4] Pathways Language Model (PaLM): Scaling to 540 Billion Parameters for Breakthrough Performance, Google Search April 4, 2022 (+)

[5] Emergent Abilities of Large Language Models, assembly AI, Mar 7, 2023 (+)

[6] Scaling Laws for Neural Language Models, Cornell University 23 Jan 2020 (+)

[7] Emergent Properties, Stanford Encyclopedia of Philosophy (+)

[8] Complex Systems

[9] Emergent Abilities in Large Language Models: An Explainer, Georgetown University April 16, 2024 (+)

[10] Elon Musk starts training ‘world’s most powerful AI’, Times of India, Jul 23, 2024 (+)

[11] Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models, University of Notre Dame (+)

[12] In-Context Learning

[13] Are Emergent Abilities of Large Language Models a Mirage? Stanford University 2023 (+)